神経科学の研究領域には、脳活動データから脳内の情報をデコードしようとする、ニューラルデコーディングと呼ばれる分野がある。デコードする情報はさまざまで、例えば運動情報をデコードすることで、四肢麻痺の患者がロボットアームを動かせるようにした研究や、脳活動のみから被験者が見ている画像を再構成するような研究もある。

中でもUCSFのEdward Chang率いるChang Labが取り組んでいるのは、脳活動データからスピーチをデコードする研究で、去年のBCI Awardでは2位を獲得している。今回は、Chang Labにてポストドクターとして従事するDavid Mosesにインタビューさせていただき、ニューラルスピーチデコーディングの現状と課題、今後の方向性について伺った。

患者の声を取り戻す。ニューラルスピーチデコーディングにかける思い

Davidのチームが行った研究で、去年のBCI Award 2021で2位を受賞した研究については、以前NeurotechJPでも紹介したので詳しくはそちらを参照して欲しいが、簡単に説明すると、埋め込んだ電極で記録した脳活動データをもとに、障害を抱える被験者が発話しようとした(が実際には聞き取ることのできない)言葉や文章を、リアルタイムで解読するというものだ。

動画: BCI Award 2021で2位を受賞した研究の説明

動画: BCI Award 2021で2位を受賞した研究の説明

Davidは他にも、機械翻訳で用いられるエンコーダーデコーダーモデルを利用した研究や、質問文を考慮した上で回答となるスピーチをデコードする研究などを行なっている。こうしたニューラルスピーチデコーディングの研究を行うことになったきっかけを、次のように語る。

今のラボ、UCSFのEdward Changラボには、2013年に、PhDプログラムの一環で参加しました。 元々Changラボではスピーチパーセプション(被験者が聞いている文章のデコード)に関する研究から始まったんですが、 そこからプロデュースドスピーチ(被験者が話している内容のデコード)に関する研究もするようになりました。

UCSFには、治療困難なてんかんを持った患者さんが訪れます。彼らの痙攣などの症状は、薬では治らず、 症状改善のためには脳の外科手術が必要です。 そこでChangのような脳外科医は、まず脳の表面にシート上の電極を貼り付ける手術を行います。 この技術はECoG (Electrocorticography, 皮質脳波記録)と呼ばれます。 ここで貼り付けた電極から、痙攣の症状の元を特定するために脳活動を計測します。 その後、痙攣を引き起こしている箇所を切り離す手術が行われます。 この時の患者さんたちが、私たちのやっているスピーチに関する研究に協力してくれます。 センサーでスピーチに関する皮質部位からの測定を行なっている間に、患者さんには文章を聞いたり、話したりしてもらいます。 そうすることで、記録した脳活動のデータと、患者さんが聞いたり話したりした文章との関係性を把握できます。 これが私がPhDの間行っていたことの基本的な内容です。

また私は、人が話している時や聞いている時の情報を、いかにリアルタイムでデコードできるかというのにも興味がありました。 それが今の研究につながっています。

Davidは二ューラルスピーチデコーディングの技術を用いて、発話の困難な患者のコミュニケーション向上を目指している。

私がPhDの時にやっていた研究では、参加していた人というのは皆さん特に問題なく発話ができる人たちでした。 ですが今やっている新しい研究は、麻痺を抱えていて発話できない患者さんにも今までやってきたことがうまくいくのかということを確かめるものです。 こうした患者さんたちは、話すことができないのでコミュニケーションをとることが難しく、他の方法に頼るしかありません。 また、私たちの実験に参加している人は、手足の運動機能にも障害があるので、腕を動かしたり、タイピングするといったことも難しいです。 彼らのコミュニケーションの選択肢は、とても限定的なものになってしまっています。 なので私にとっての長期的な目標は、 発話が困難で自然な会話が難しい人々の声を取り戻してあげられるような、実用的で、信頼性の高い技術を開発することです。 この技術が、デバイスのコントロールを行い、介護士の人や、家族、友人とのスピーチを用いたコミュニケーションに対する一つの選択肢となるでしょう。

そもそも本当にうまくいくかもわからなかった。発話に障害のある人からもスピーチのデコーディングが可能であることを示す

上でも紹介した、BCI Award 2021で2位を受賞した研究において、Davidはリーダーとしてチームをまとめた。

私のこのプロジェクトでの役割は、チームをリードすることでした。Chang博士がPIで、全てを監督していたんですが、 私はタスクのデザイン決定を率いたり、データが正しく集められ解析されているかを確認したり、リアルタイムで処理するプログラムを書いたりと、 研究や論文執筆に関する様々な部分を調整していました。

ニューラルスピーチデコーディング自体は他にもいくつかの研究が既になされていたが、それらの多くは、発話に障害のない被験者に対して実験されることが多かった。一方で、BCI Awardでの研究では、実際に発話に障害がある被験者に対しても、スピーチのデコードが可能であることを示した。この研究において難しかった点を、Davidは次のように語る。

まずは実験を準備して進めたり、被験者を募集したりといった、手続き的な大変さがありました。 私は被験者募集に直接関わっていたわけではないですが、実際に実験を始められるように全てを整えておくことは、 とても大変なことだったと思います。

実際の研究手法的な難しさでいうと、失敗し得る箇所はいくつもありました。何が一番困難だったかを言うのは難しいですが、 人間の脳についてはまだ明らかになっていないことだらけで、何一つうまくいかないということすらあり得ました。 電極を埋めて、被験者が話そうと試みても、神経信号に重要な情報が載っていなくて、結局何を言おうとしているのか判別できない。 そんなことが起こる可能性すらあったわけです。

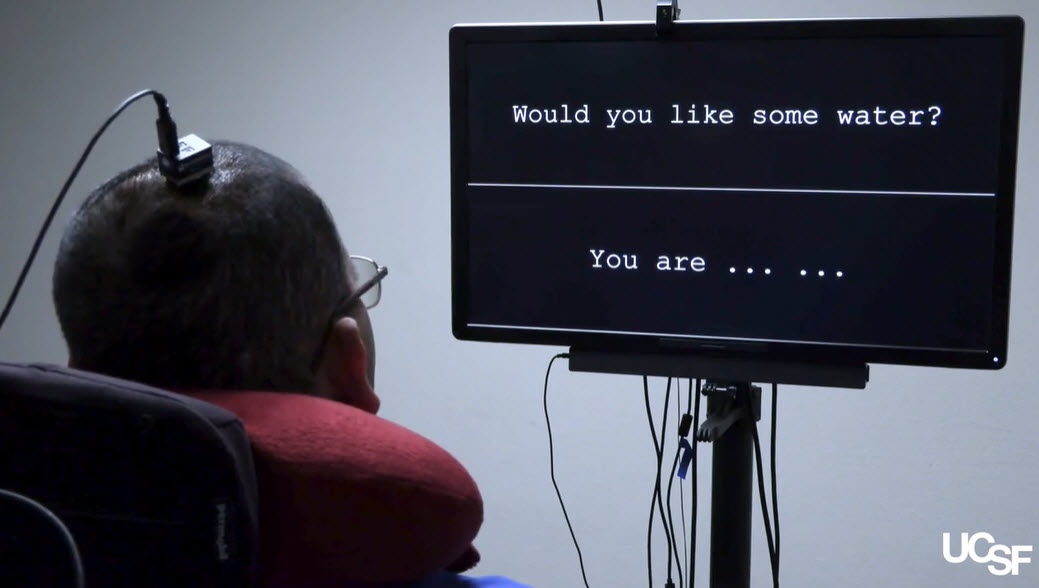

画像: 実験の様子(Neuroprosthesis for Decoding Speech in a Paralyzed Person with Anarthria)

画像: 実験の様子(Neuroprosthesis for Decoding Speech in a Paralyzed Person with Anarthria)

ニューラルスピーチデコーディングにおける三つの難点

Chang Labを筆頭に、ニューラルスピーチデコーディングについての研究は進んできているものの、まだまだその精度には改善の余地があるように思える。ニューラルスピーチデコーディングにおける困難な点はどこにあるのだろうか。

この点について、Davidは以下の三点を挙げている。

- 正解データのアラインメント

自然に話すことができない人のスピーチをデコードする際に難しいこととしては、 正解データのアラインメントです。 発話をしている人のスピーチをデコードする場合は、その人がいつ何を言ったが正確にわかりますが、 話すことができない被験者の場合、神経データと、期待されるスピーチとのアラインメントを取るのはとても難しくなります。

- ノイズ

また、神経活動データからデコードする場合は、例えば音の波形からデコードする場合と比べて、 ノイズの問題もあります。 脳活動というのは単にデータを記録するときにノイズが乗りやすいだけでなく、スピーチと関係ないバックグラウンドでの処理も走っているからです。 なので、例えば空間解像度や記録できる脳の範囲が上がるなど、ハードウェアが良くなれば、 スピーチのデコーディング精度においても更なる発展が見込めると思います。

- デコーダーの汎化性能

最後に、汎化性能の問題もあります。 今の患者数の少なさだと、脳活動からスピーチを読み取る、汎化性能の高いデコーダーを作ることはとても難しいです。 私たちの研究では50単語の分類でしたが、例えば1000単語の分類などとなると、新しいモデリングの方法が必要になるでしょう。 少ない種類の単語ではなく、膨大な種類の単語を分類することは、とても大きな挑戦だと思います。

実用化に向けて、今後ニューラルスピーチデコーディングが超えるべき課題

現在、アイトラッキングによる文字入力などは、既に実用化され、患者の意思疎通のためのツールとして用いられているケースもある。しかしながら、ニューラルスピーチデコーディングはまだまだ実用化には至っていない。研究としてだけでなく、実際に患者が使えるようになるのはいつ頃なのだろうか。

この点について、Davidは乗り越えるべき問題がいくつもあるという。

私は、いくつもハードルがあると思います。科学的、技術的なハードルに加えて、規則的なハードルもあります。 脳外科手術を受ける人々が、きちんと役に立つ効果を得られるということを示すのは重要なことです。 しかしながら、それらを乗り越えるのにはある程度時間がかかると思います。 正確なタイムラインを述べるのは難しいですが、重症患者にとってのコミュニケーションを、商業的な方法で改善するには、 まだ数十年はかかると思います。 もしかしたら5年以内、なんてこともあるかもしれませんが、まだわからないです。

はっきりとしたことを言うには、今行っている一人の被験者以上に、もっと多くの被験者で実験をしたいと思います。 もし大勢の、異なる障害を持つ被験者で実験した結果、被験者の言おうとしていることが、 ある程度実用的なレベルでデコードでき、かつBCIを用いないコミュニケーションの手段よりも良いとわかったら、 実用化までのタイムラインはもっと短いものになると言えるでしょう。

一方で、Chang LabはかつてMeta社(旧Facebook社)も興味を示し、研究資金の支援などを行っていた。Meta社としてはこうした技術を医療応用以外にも広げたいという思いがあるように見えるが、この点についてDavidは、現状障害のない人に対してこの技術を応用することは考えていないという。

現状、一般の人に対しての応用は全く考えていません。 現段階で、喫緊の必要がないのに、スピーチをデコードするために脳に自分から電極を埋め込もうとする人がいるとは、想像しにくいです。 絶対にないとはいいませんが、スピーチのためのものというよりは、何か根本的に違うアプリケーションのために使われる気がします。

Meta社の件に関して私の理解では、スマートフォンなどを、声や視線を使わずに、コントロールできるような非侵襲のBCIを作りたかったんだと思います。 彼らが私たちの研究に出資していた理由は、私たちが麻痺を抱えた人々を助けるという観点でやっている研究に共感し、 侵襲型の手法での限界を知りたかったからであって、彼ら自身が侵襲型で何かやりたかったという訳ではないと思います。

現在、彼らからの出資はもうすでに終わっていて、Meta社もEMGを用いたコントロールの方により注力することにした、 ということをアナウンスしていましたね。

/cdn.vox-cdn.com/uploads/chorus_image/image/68988252/Visual_3.0.png) 画像: Meta社が開発を進める、EMGを利用したリストバンド

画像: Meta社が開発を進める、EMGを利用したリストバンド

最後に、David自身が今後どういった道を歩んでいくのかについても伺った。

今はまだ、現在進行中のプロジェクトの短期目標に集中しています。 なので、まだまだ麻痺患者に対する研究を行なって、この技術の実用化に近づけたいと思っています。 実際にこの技術が実用化されるのをみることができたら、とても面白いでしょうね。

さいごに

今回、Chang Labでポスドクを務めるDavidにインタビューをさせていただいた。

インタビューの最後に、Davidが所属するChang Labではどんなスキルを求められるかを尋ねたところ、これは研究室を代表する意見ではなく、ラボ全体を見渡した時の個人の意見であると前置きした上で、Pythonを使った機械学習、特にスピーチ関連の知識があると良いということを一番に述べていた。さらに神経科学の知識に関しては、ラボで行われる研究の特性上、細胞レベルでの理解は必ずしも必要ないが、脳がどのようにして複雑な振る舞いを制御しているのかという、システムレベルでの神経科学の知識はあると良いだろうとのことだった。

今後Chang Labを筆頭にスピーチデコーディングの研究が進み、スピーチや運動機能に障害を抱えた人であっても、スムーズなコミュニケーションが可能になる世界の実現を心待ちにしている。